Дипфейки: Очередная опасность для криптопользователей?

This article has not been translated yet.

Рассказываем о новых технологиях, которые могут нанести потенциальный вред владельцам цифровых активов

18.05.2024

692

11 min

0

Что такое дипфейки?

Дипфейки — это синтезированные медиаматериалы, созданные с использованием искусственного интеллекта. В последние годы дипфейки привлекли огромное внимание общественности и вызвали беспокойство по всему миру. Они могут быть использованы как в играх и кинематографе, так и для создания поддельных новостей, манипуляций, мошенничества, шантажа и других негативных целей.

Основная особенность дипфейков заключается в возможности изменять лицо или голос человека на видео или аудиозаписи. С помощью сложных алгоритмов и моделей глубокого обучения ИИ может, например, перенести лицо одного человека на тело другого в видеоролике таким образом, что это будет выглядеть крайне реалистично. Также возможно скомбинировать различные элементы изображений для создания нового контента.

Алгоритмы обучаются на большом количестве изображений и видео, чтобы понимать структуру и детали разных объектов, лиц людей и их выражения. Затем они могут применять это знание для создания новых материалов, подделки отдельных элементов на существующих изображениях или создания полностью нового контента. С помощью таких технологий можно создавать видео или аудиозаписи, которые кажутся достоверными, но на самом деле содержат неправдивые утверждения или искаженную информацию. Это может быть использовано для манипулирования общественным мнением или мошенничества.

Как криптомошенники используют дипфейки?

В мире криптовалют не обошлось без использования новой технологии. Мошенники создают и используют дипфейки, чтобы выдавать себя за известных людей, связанных с миром криптовалют, распространять дезинформацию и продвигать фейковые криптопроекты.

В некоторых случаях мошенники от лица криптоэкспертов распространяют дезинформацию о конкурсах и аирдропах или предлагают пользователям вложить средства в проект, обещая большую прибыль. Они могут вызывать доверие, поскольку выглядят как известные личности, которые бы точно не стали заниматься скамом. Пользователи, не знакомые с подобным видом мошенничества, вкладывают цифровые активы, а через время злоумышленники закрывают возможность вывести инвестиции и исчезают.

По мнению представителей криптобиржи Binance, самое уязвимое место для атаки дипфейков — система идентификации KYC («Знай своего клиента»). По словам директора по безопасности платформы Джимми Су, под угрозой могут оказаться личная информация и средства пользователей:

«Некоторые процессы верификации запрашивают у пользователя моргнуть левым глазом или посмотреть влево или вправо, вниз или вверх. Дипфейки сейчас достаточно продвинуты и научились выполнять такие команды».

В Binance рассказали об использовании ИИ-технологий для обхода KYC

Директор по безопасности платформы предупредил, что со временем дипфейки станут более совершенными

Об этой проблеме в Binance рассказали еще год назад, а в феврале текущего года стало известно, что сгенерированные с помощью ИИ-сервиса OnlyFake поддельные удостоверения личности успешно проходят проверки криптобирж в рамках KYC-процедуры. Созданные сервисом «фотографии» паспортов несуществующих людей, якобы сделанные в реалистичной обстановке, принимаются платформами Binance, Kraken, Bybit, HTX и Coinbase, а также онлайн-банком Revolut.

Случаи использования дипфейков криптомошенниками

В декабре 2023 года основатель блокчейна Cardano Чарльз Хоскинсон прокомментировал созданное мошенниками видео, в котором его точная копия в прямом эфире анонсировала будущую раздачу токенов ADA. Он поделился предположением , что в ближайшие годы уровень генеративного искусственного интеллекта достигнет таких масштабов, что обычному человеку будет сложно отличить реального человека от дипфейка.

Он также прогнозировал, что к июню 2024 года с помощью генеративного ИИ будут украдены токены ADA стоимостью в миллионы долларов.

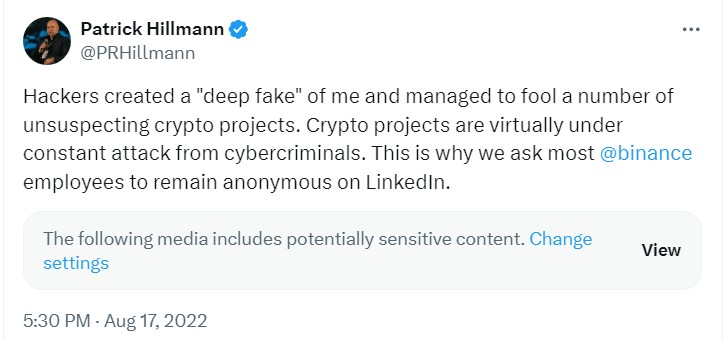

В августе 2022 года директор по коммуникациям Binance Патрик Хиллманн предупредил, что команда хакеров использовала его интервью и выступления на телевидении, чтобы создать его дипфейк.

Затем лицо Хиллманна было использовано для проведения Zoom-встреч с командами криптопроектов, где была обещана возможность разместить их активы на Binance за определенную плату.

В ноябре 2022 года в Х появилось дипфейк-видео, где основатель FTX Сэм Бэнкман-Фрид пообещал компенсацию всем, кто пострадал от краха криптобиржи. Он уверял, что в качестве компенсации подготовил бывшим клиентам проект, на котором те смогут удвоить свои инвестиции. На самом деле предложенная ссылка вела на мошенническую платформу. Подробнее об этой ситуации мы рассказывали в статье «Компенсации, раздачи и дипфейки. Как мошенники используют крах FTX».

Большой популярностью у криптомошенников пользуется личность главы Tesla и X Илона Маска. В мае 2022 года злоумышленники использовали дипфейки Маска и других известных личностей в криптосфере, чтобы продвигать мошенническую платформу BitVex. В видеоролике якобы Илон Маск рассказал, что создал проект BitVex, где каждый получит до 30% прибыли от депозитов. На это обратили внимание специалисты компании-разработчика антивирусного ПО McAfee.

Медиакомпания Fox запустила на Polygon протокол для борьбы с дипфейками

СМИ могут зарегистрировать в протоколе свои материалы, чтобы подтвердить их достоверность

В августе 2020 года на YouTube появилась реклама, в которой от лица Маска говорилось о бесплатной раздаче биткоинов. Реклама была показана во время просмотра видео. Мошенники предлагали отправить криптовалюту на кошелек фейкового Илона Маска и якобы получить в два раза больше. Об этом писал РБК.

Можно ли обезопасить себя от мошенничества?

Может показаться, что отличить настоящее выступление криптоэксперта от дипфейка невозможно, однако есть несколько правил, которые помогут не попасть в сети мошенников. На что обратить внимание, если вы заподозрили признаки мошенничества с использованием искусственного интеллекта:

Необычные заявления о цифровых активах. Скептически относитесь к контенту, в котором спикер делает необычные заявления относительно криптоинвестиционных проектов, например гарантирует прибыль или дает инсайдерские советы.

Непоследовательное поведение. Если инфлюенсер поддерживает криптопроект, который кажется нехарактерным или противоречит его ранее озвученным публично убеждениям и ценностям, это может быть дипфейком.

Манипуляции с голосом и видео. Обращайте внимание на расхождения в качестве голоса и видео. Видео, смонтированные с помощью ИИ, могут демонстрировать едва заметные сбои или неестественные особенности.

Искусственный интеллект с каждым годом развивается все больше, предлагая объективные преимущества. Однако недобросовестные люди могу использовать его во вред другим. За последние несколько лет участились случаи, когда лицо медийной личности используется для мошеннических схем.

Новичкам в криптопространстве следует быть особенно осторожными, чтобы не попасть в сети злоумышленников, которые выдают себя за трейдеров или сотрудников криптобирж. Помните и о безопасности и обязательно проводите собственные исследования, прежде чем вкладывать средства в проект. Инвестируйте ровно столько, сколько вы можете позволить себе потерять.

Useful material?

Articles

How the largest cryptocurrency exchange’s initiatives help it maintain its leadership

Nov 19, 2022

Articles

What fan coins are needed for and what events contribute to their growth

Nov 16, 2022

Articles

Why Binance set the trend to publish transparent data on available funds

Nov 14, 2022

Articles

The journalists got acquainted with the documents revealing the details of the financial condition of the exchange

Nov 13, 2022

Articles

Desperate traders with stuck assets resort to semi-legal schemes to save deposits

Nov 11, 2022

Articles

Experts predict when to expect new peaks of the crypto market by analyzing its previous cycles

Nov 10, 2022

Telegram

Telegram  Twitter

Twitter